Introducción a la Inteligencia Artificial Generativa

La Inteligencia Artificial Generativa (Generative AI) es un campo de la IA que permite la creación de contenido nuevo, como texto, imágenes, código y otros formatos digitales.

Su impacto ha revolucionado la manera en que interactuamos con la tecnología, facilitando la automatización y personalización de múltiples procesos.

¿Qué es la Inteligencia Artificial Generativa?

La IA generativa se basa en modelos de aprendizaje profundo que pueden generar contenido original a partir de datos de entrenamiento. Su uso se ha expandido a múltiples industrias, desde la educación hasta la generación de código, ofreciendo soluciones innovadoras con tan solo una instrucción en lenguaje natural.

Lo que hace a esta tecnología tan poderosa es su capacidad de democratizar la inteligencia artificial, permitiendo que cualquier persona sin conocimientos técnicos avanzados pueda generar contenido utilizando modelos como los de OpenAI (GPT), Google (Gemini) y otros.

¿Cómo llegamos a la Inteligencia Artificial Generativa?

A pesar del gran revuelo que ha causado la IA generativa en los últimos años, esta tecnología ha estado en desarrollo durante décadas. Los primeros intentos de IA se remontan a los años 60 con los primeros chatbots basados en reglas, como ELIZA, que utilizaban respuestas predefinidas según palabras clave. Sin embargo, estos sistemas eran muy limitados y no podían escalar de manera eficiente.

Durante la década de los 90, la IA dio un salto significativo con la introducción del aprendizaje automático (Machine Learning). Este enfoque permitió que las máquinas aprendieran patrones a partir de datos sin necesidad de ser explícitamente programadas para cada tarea. En el ámbito del procesamiento del lenguaje natural, esto se tradujo en modelos capaces de identificar y clasificar texto según patrones aprendidos.

El avance del hardware en los años 2000 permitió manejar cantidades masivas de datos y cálculos más complejos, lo que llevó al desarrollo de redes neuronales avanzadas, en particular las Redes Neuronales Recurrentes (RNNs). Estas mejoraron la capacidad de las máquinas para comprender el contexto del lenguaje y responder con mayor coherencia. Esta tecnología fue la base para asistentes virtuales como Siri, Alexa y Google Assistant.

El gran salto hacia la IA generativa se dio con la llegada de los modelos Transformer, que superaron las limitaciones de las RNNs al permitir procesar secuencias de texto mucho más largas y con mayor precisión. Modelos como GPT-3, GPT-4 y DALL·E han revolucionado la generación de contenido digital, permitiendo desde la creación de textos complejos hasta la generación de imágenes realistas.

¿Qué son los Modelos de Aprendizaje?

Los modelos de aprendizaje son algoritmos de inteligencia artificial diseñados para reconocer patrones en los datos y hacer predicciones o generar contenido basado en ese conocimiento. Estos modelos se entrenan utilizando grandes cantidades de información, lo que les permite mejorar su precisión y aplicabilidad con el tiempo.

Existen diferentes tipos de modelos de aprendizaje en IA:

- Aprendizaje supervisado: El modelo es entrenado con datos etiquetados, es decir, entradas con una respuesta esperada. Se usa en tareas como clasificación de imágenes y predicción de valores.

- Aprendizaje no supervisado: El modelo analiza datos sin etiquetas para identificar patrones y agrupaciones. Se usa en segmentación de clientes y detección de anomalías.

- Aprendizaje por refuerzo: Basado en un sistema de recompensas, donde el modelo aprende mediante prueba y error. Se usa en juegos y automatización de procesos complejos.

Dentro de la IA generativa, los modelos más utilizados son los redes neuronales profundas y los modelos Transformer, como GPT y BERT, que permiten entender y generar texto con una fluidez cercana a la humana.

¿Qué es un Token en los Modelos de Lenguaje?

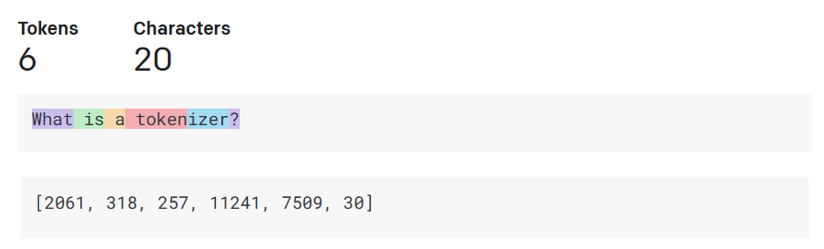

En el contexto de los Modelos de Lenguaje de Gran Escala (LLMs, por sus siglas en inglés), un token es la unidad mínima de texto que un modelo puede procesar. Los tokens pueden representar palabras completas, fragmentos de palabras o incluso caracteres individuales, dependiendo de cómo se haya diseñado el tokenizador.

¿Cómo funcionan los Modelos de Lenguaje de Gran Escala (LLMs)?

Los modelos de lenguaje de gran escala, como GPT, funcionan mediante una serie de procesos que les permiten entender y generar texto de manera eficiente:

-

Tokenización: El texto de entrada se divide en fragmentos más pequeños llamados "tokens".

-

Entrenamiento con grandes volúmenes de datos: Los modelos son expuestos a enormes conjuntos de datos para aprender patrones lingüísticos.

-

Mecanismo de atención: Utilizan el mecanismo de self-attention para analizar el contexto de una oración antes de generar la siguiente palabra.

-

Generación de contenido: Predicen las palabras más probables para continuar un texto, asegurando coherencia y relevancia.

-

Control de creatividad: Parámetros como "temperatura" y "top-k sampling" regulan la creatividad y aleatoriedad en las respuestas generadas.

Gracias a estos procesos, los LLMs han demostrado ser extremadamente útiles en la automatización de tareas, desde la generación de texto hasta la asistencia en programación y análisis de datos.

🎯 Asesoría Diagnóstica de Empleabilidad Tech

¿Postulando y no te llaman o no sabes por qué te filtran?

En 60 minutos evaluamos tu CV/LinkedIn, tu nivel real de mercado y te dejamos un plan priorizado para las próximas 2 semanas.

Aplicaciones prácticas de la IA Generativa

Los avances en IA generativa han permitido su adopción en múltiples industrias. Algunos de los usos más destacados incluyen:

- Educación: Creación de tutores virtuales, generación automática de materiales de estudio y personalización del aprendizaje.

- Salud: Análisis de historias clínicas, generación de informes médicos y apoyo en diagnósticos.

- Marketing y Contenido: Automatización de publicaciones en redes sociales, generación de contenido publicitario y redacción de artículos.

- Desarrollo de Software: Generación de código, depuración automática y documentación técnica.

- Entretenimiento y Diseño: Creación de guiones, generación de arte digital y producción de música.

Uno de los casos más impactantes es la creación de asistentes virtuales avanzados capaces de mantener conversaciones naturales y brindar soporte en tiempo real.

Desafíos y Consideraciones Éticas

A pesar de los avances y beneficios que ofrece la IA generativa, su implementación plantea desafíos significativos que deben abordarse para garantizar su uso seguro y ético:

- Calidad y veracidad del contenido: Los modelos pueden generar información errónea o sesgada, lo que puede afectar la toma de decisiones basada en datos incorrectos. La falta de verificación de hechos sigue siendo un problema clave.

- Seguridad y uso malintencionado: Existe el riesgo de generar contenido engañoso, como deepfakes y desinformación, lo que puede ser utilizado con fines fraudulentos o manipulación social.

- Sesgo en los datos: Dado que estos modelos se entrenan con datos históricos, pueden perpetuar estereotipos y prejuicios presentes en los conjuntos de datos de entrenamiento, generando respuestas discriminatorias o parciales.

- Privacidad y protección de datos: El uso de información sensible sin controles adecuados puede violar regulaciones como GDPR o CCPA, lo que plantea preocupaciones sobre la privacidad y el uso indebido de datos personales.

- Regulación y supervisión: Es necesario establecer normativas claras que regulen el desarrollo y uso de IA generativa, asegurando transparencia, explicabilidad y responsabilidad en su implementación.

El futuro de la IA generativa dependerá de cómo abordemos estos desafíos, equilibrando innovación con responsabilidad para maximizar su impacto positivo sin comprometer la seguridad y la ética.

Que es el parámetro de la temperatura?

El parámetro de temperatura en los modelos de lenguaje de gran escala (LLMs) es un factor clave que influye en la creatividad y diversidad de las respuestas generadas. Se trata de un valor numérico que regula la probabilidad de selección de las palabras que el modelo genera en función de su entrenamiento.

¿Cómo funciona la temperatura en un LLM?

Cuando un modelo de lenguaje genera texto, evalúa múltiples posibles palabras para completar una oración y asigna probabilidades a cada una. El parámetro de temperatura ajusta la forma en que estas probabilidades influyen en la selección final:

- Temperatura baja (cercana a 0, por ejemplo, 0.2 o 0.5): El modelo elige las palabras con la mayor probabilidad, lo que genera respuestas más predecibles y coherentes. Esto es útil en aplicaciones donde la precisión es crucial, como la generación de respuestas en asistentes virtuales o en sistemas de búsqueda de información.

- Temperatura alta (cercana a 1.0 o mayor): El modelo introduce más aleatoriedad en la elección de palabras, permitiendo mayor diversidad y creatividad en la generación de texto. Esto es útil en tareas como escritura creativa, generación de diálogos o composición de contenido más innovador.

Ejemplo práctico

Si se le pide a un modelo que complete la oración:

"El cielo es..."

- Con temperatura baja (0.2): Es probable que el modelo complete con palabras altamente predecibles como "azul" o "gris".

- Con temperatura alta (1.0 o más): La respuesta podría incluir términos inesperados como "una vasta explosión de colores" o "un lienzo infinito de estrellas danzantes".

Aplicaciones del control de temperatura

- Chatbots y asistentes virtuales: Se usa una temperatura baja para mantener respuestas consistentes y predecibles.

- Generación de historias y creatividad: Se usa una temperatura alta para permitir mayor variabilidad y expresión original.

- Traducción automática y resúmenes: Se emplea una temperatura moderada para garantizar fidelidad al texto original sin perder naturalidad.