¿Qué es Fine Tunning?

En los últimos años, los modelos de lenguaje de gran escala (LLMs) como GPT-4, LLaMA o Claude han transformado radicalmente la forma en que las aplicaciones procesan texto, generan contenido y automatizan tareas. Pero aunque estos modelos son asombrosamente poderosos desde el primer momento, muchas veces no se ajustan exactamente a lo que un proyecto necesita: un estilo específico, un vocabulario técnico, una lógica de negocio o incluso una personalidad de marca.

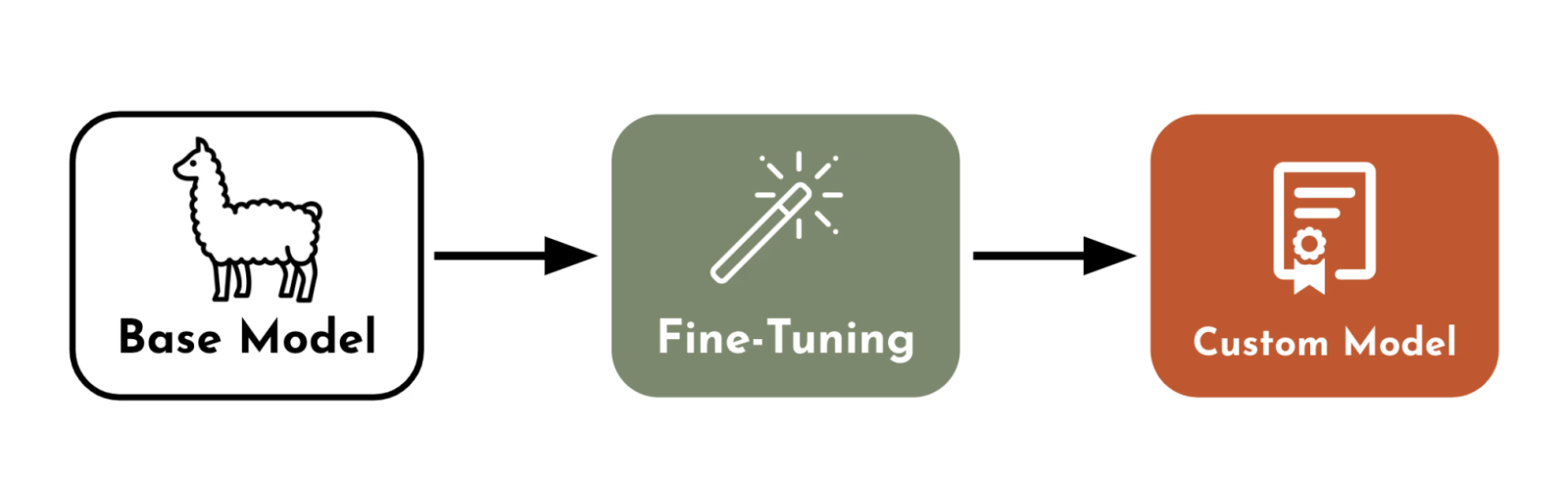

Aquí es donde entra el concepto de fine-tuning, una técnica que te permite personalizar un modelo de lenguaje preentrenado para que entienda mejor tu contexto, tus usuarios y tus objetivos.

Este artículo te enseñará qué es el fine-tuning, cuándo usarlo, en qué se diferencia de otras estrategias como RAG, y cómo puedes comenzar incluso si estás dando tus primeros pasos como developer.

¿Qué es el Fine-Tuning?

El fine-tuning (o ajuste fino) consiste en tomar un modelo de lenguaje ya preentrenado sobre grandes volúmenes de texto (como Wikipedia, Reddit, libros, artículos científicos) y reentrenarlo brevemente con un conjunto de datos específico para una tarea o dominio.

A diferencia del entrenamiento desde cero (que puede costar cientos de miles de dólares), el fine-tuning solo requiere una fracción del tiempo, energía y datos. El resultado es un modelo que responde de forma más precisa, confiable y personalizada en tu caso de uso.

¿Para qué sirve el Fine-Tuning?

Adaptarse a un dominio específico

Supón que trabajas en una fintech, un e-commerce o una startup de salud. Puedes hacer que el modelo entienda el vocabulario, siglas, procesos y tono técnico que manejas, algo que un modelo generalista no hace con precisión.

Crear un estilo de comunicación único

Puedes entrenar a tu modelo para que escriba como tu marca: amigable, técnico, formal, juvenil o incluso con humor. Esto es ideal para chatbots, generadores de contenido o asistentes conversacionales.

Aumentar precisión en tareas estructuradas

Casos como extracción de datos, generación de código estandarizado, clasificación de tipos de preguntas o generación de contratos legales pueden beneficiarse de un modelo que aprendió exactamente cómo esperas los resultados.

¿Cuál es la diferencia con RAG?

Muchos proyectos usan RAG (Retrieval-Augmented Generation), que consiste en darle al modelo acceso a una base de conocimientos para que pueda recuperar información y responder mejor. RAG no modifica el modelo, mientras que el fine-tuning ajusta su comportamiento interno.

| Técnica | ¿Modifica el modelo? | ¿Cuándo usarla? |

|---|---|---|

| Fine-Tuning | Sí | Cuando necesitas precisión, estilo o lógica propia |

| RAG | No | Cuando necesitas respuestas con datos externos, actualizados o cambiantes |

En resumen: si tu contenido cambia mucho (como una base de productos), usa RAG. Si tu estilo o reglas son fijas y especializadas, considera el fine-tuning.

🎯 Asesoría Diagnóstica de Empleabilidad Tech

¿Postulando y no te llaman o no sabes por qué te filtran?

En 60 minutos evaluamos tu CV/LinkedIn, tu nivel real de mercado y te dejamos un plan priorizado para las próximas 2 semanas.

¿Cómo se hace fine-tuning?

1. Preparar el dataset

Necesitas pares de prompt y completion. Aquí un ejemplo simple:

{"prompt": "¿Qué es un pagaré?", "completion": "Es un documento legal que compromete a una persona a pagar una suma de dinero."}

Puedes comenzar con tan solo 100 a 500 ejemplos bien elaborados.

2. Elegir el modelo base

Algunos modelos populares para fine-tuning:

- OpenAI: GPT-3.5 y modelos base (curie, davinci)

- Meta: LLaMA 2

- Mistral, Zephyr, Gemma: modelos open-source

- Google: Gemini Pro (en beta para ajuste fino)

3. Elegir el enfoque: Fine-tuning clásico vs LoRA

- Fine-tuning clásico: Reentrenas todos los parámetros. Requiere GPU y puede ser caro.

- LoRA (Low-Rank Adaptation): Técnica que entrena solo capas ligeras. Mucho más eficiente, ideal para desarrolladores independientes o en ambientes cloud.

4. Entrenar y evaluar

Puedes usar:

- Hugging Face +

transformers+peft+ Google Colab - OpenAI CLI si usas sus modelos

- Plataformas como Replicate, Sagemaker o Paperspace

Evalúa:

- ¿Las respuestas son más coherentes?

- ¿El modelo entendió los matices de tu dominio?

- ¿El estilo cambió según lo esperabas?

5. Desplegar

Una vez entrenado, puedes exponer tu modelo como API REST o integrarlo en una aplicación web o móvil. Puedes alojarlo en Hugging Face Hub, en un servidor privado o usarlo localmente con aceleración.

Herramientas recomendadas para comenzar

- Hugging Face Transformers: biblioteca clave para trabajar con modelos preentrenados.

- Google Colab: entrena gratis con GPU.

- Datasets públicos: usa Hugging Face Datasets para experimentar.

- Axolotl: framework CLI para fine-tuning eficiente.

- OpenAI CLI: para entrenar modelos GPT con JSONL.

Buenas prácticas para nuevos developers

- Empieza con un caso real tuyo: como un chatbot que responda preguntas sobre tu portafolio o tu empresa.

- Mantén ejemplos simples pero claros.

- Evalúa resultados con usuarios reales o test automáticos.

- Evita sobreajustar (overfitting): usa variedad de ejemplos.

- Guarda versiones de tu modelo entrenado: para comparar mejoras.